Разбор текста по плану пример: План анализа текста | Учебно-методический материал по русскому языку (6 класс) на тему:

Как делать анализ текста: план и шаги

Каждый ученик задает вопрос: как делать анализ текста, когда приходит время выполнять такое задание. Первое, с чего стоит начать — составить план. А далее, следуя по шагам, проанализировать предложенный текст. На самом деле, ничего сложного.

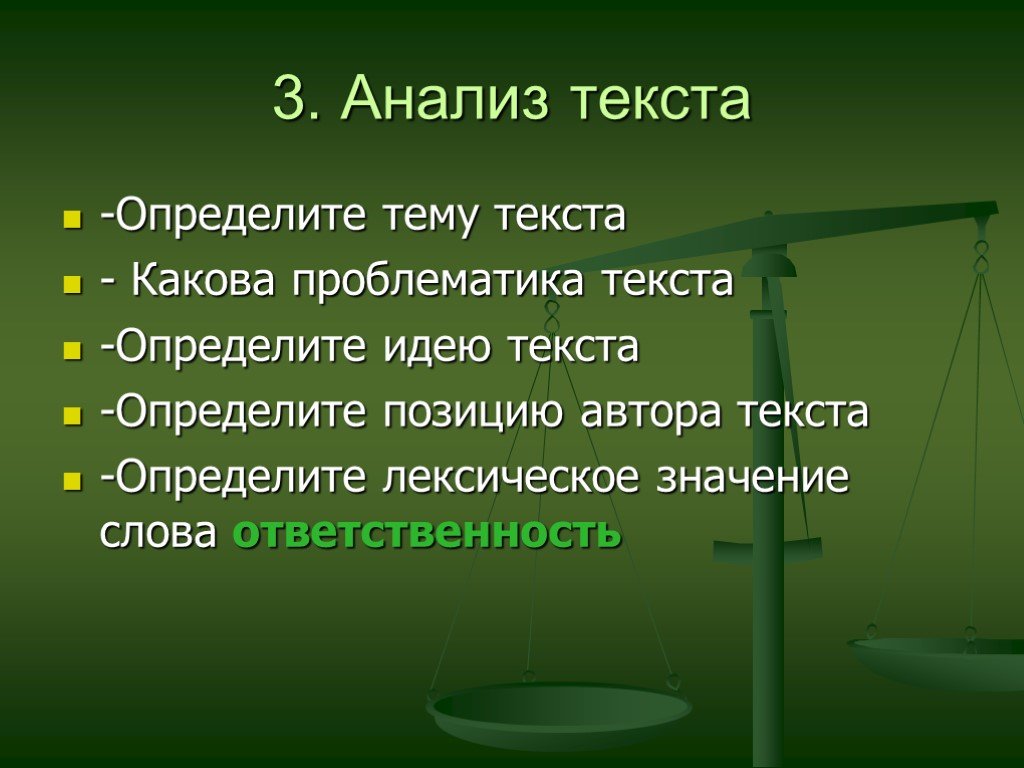

Что такое анализ текста?

Итак, подробнее. Анализ — это метод краткого описания (краткий пересказ), чтобы лучше понять смысл. Анализировать можно все что угодно: стихотворение, текст, поступок, сказанные слова и так далее. Главное, соблюдать некоторые правила. Что же касается анализа текста по школьным предметам (литературе или русскому языку), то данное занятие помогает не просто читать книги, а читать осмысленно. Так, чтобы после прочтения можно было легко пересказать произведение и уловить мысль автора. Конечно на первых этапах ученик будет задавать себе вопрос, как делать анализ текста. Но впоследствии ему станет легче понимать произведения, когда они станут более сложными. Данный метод работы также помогает настраиваться на творческую работу и раскрывает личностное восприятие.

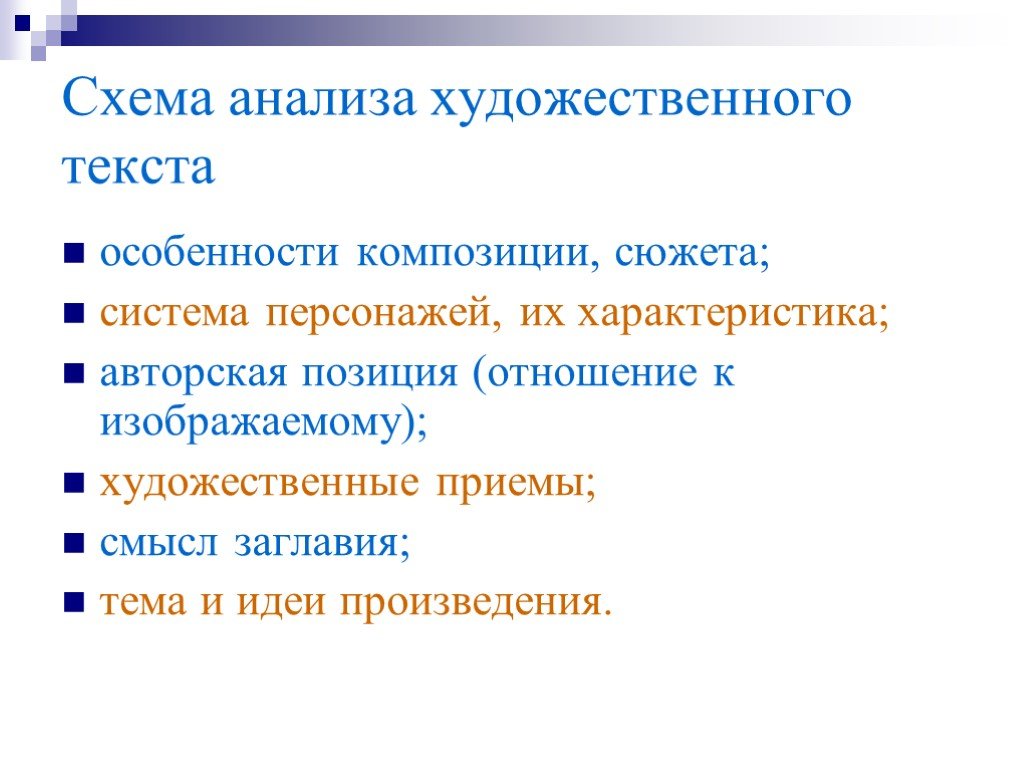

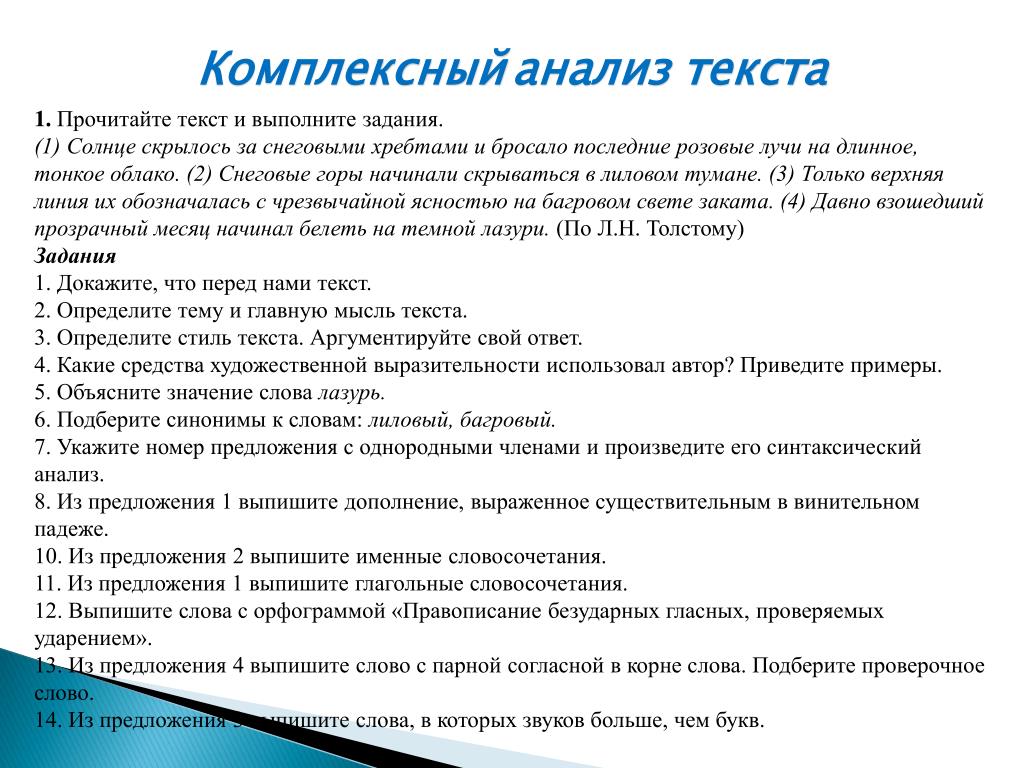

Комплексный анализ текста

Данное задание включает в себя множество параметров, по которым легче понять отрывок из произведения. Но четкой инструкции или схемы не существует, хотя придерживаться какого-то плана необходимо, чтобы составить текст анализа, где вывод будет вытекать из определенных фактов, подтверждающихся приведенными аргументами.

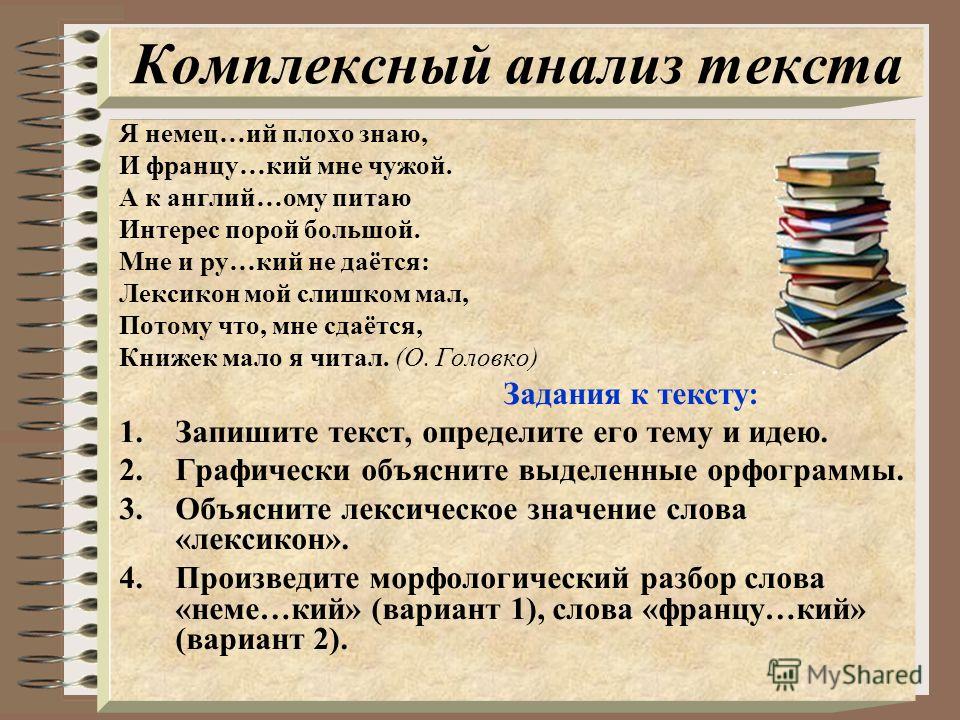

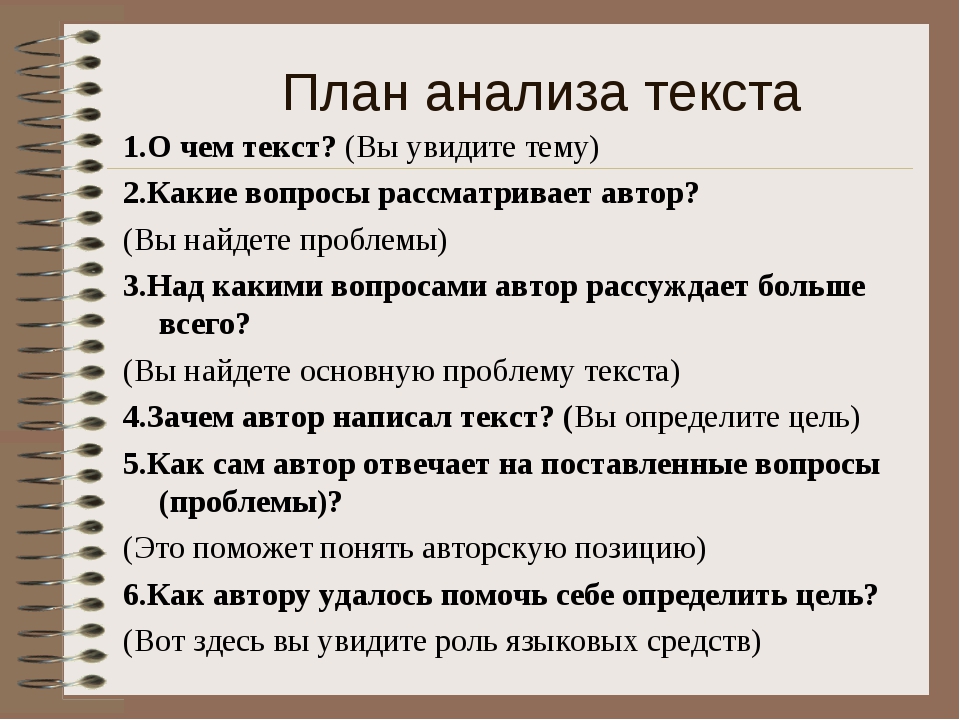

Стоит начать с того, что после прочтения, необходимо озаглавить текст. Так для себя можно определить тему и тематику и уже вначале ответить на вопрос: «что этим отрывком автор хотел сказать?».

Стоит помнить, что тема — это предмет рассуждения. А тематика — это совокупность тем, которые могут быть в предложенном отрывке.

В помощь при анализе могут быть использованы средства связи, разделяющиеся на лексические и морфологические. Т.е. необходимо определить, используются ли синонимы, повторы, союзы, глаголы и деепричастия.

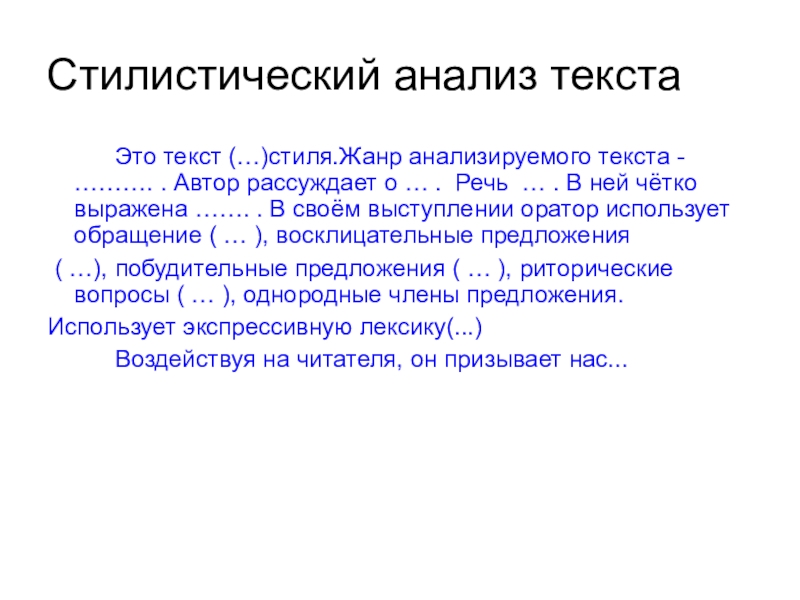

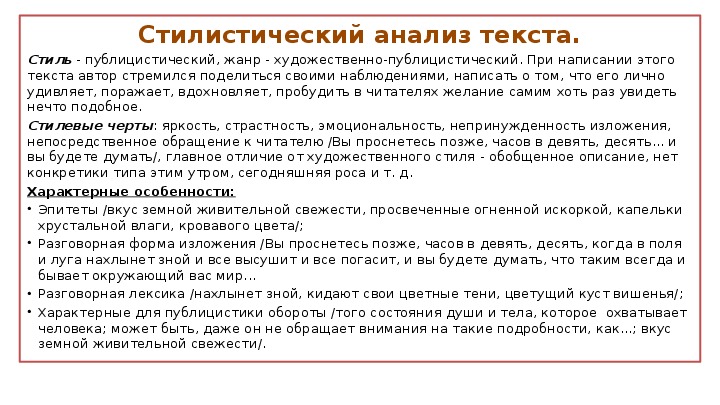

Упомянуть нужно и о стиле текста, который может быть художественным, официально-деловым, научным или разговорным. А также следует уточнить, какой используется тип речи: повествование, рассуждение или описание.

А также следует уточнить, какой используется тип речи: повествование, рассуждение или описание.

Знание всех моментов несомненно поможет при разборе, и ученик уже не будет задавать вопрос: а как делать анализ текста. Он сразу по определенному плану начнет исследовать предложенное произведение, и в конце легко сможет сделать вывод с приведенными аргументами.

По русскому языку и литературе

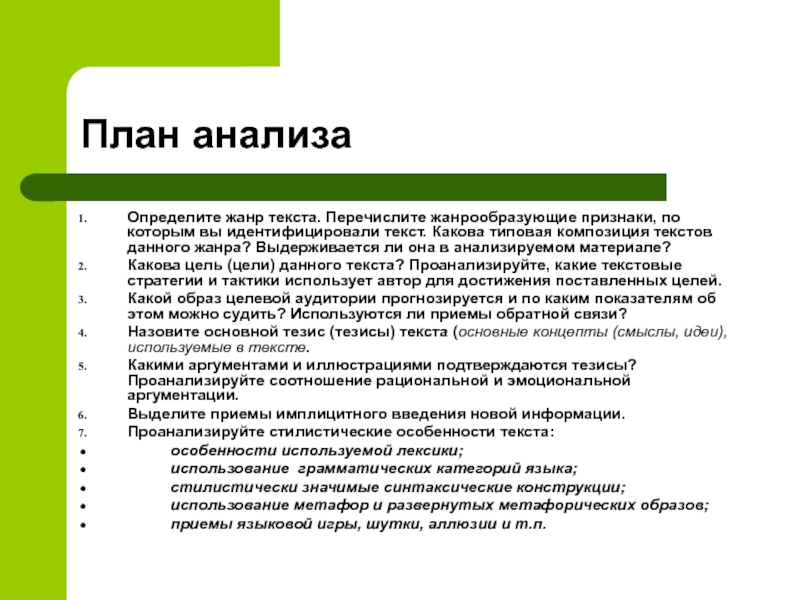

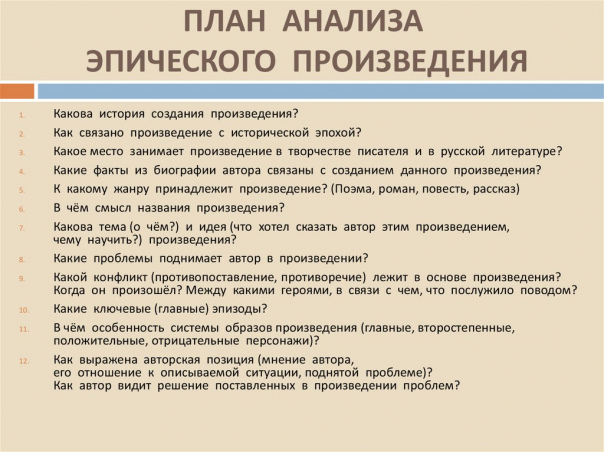

И напоследок. Анализы текстов по русскому языку и литературе могут несколько отличаться друг от друга. Если он взят из какого-либо произведения, необходимо использовать несколько одинаковых шагов. По-порядку:

- Жанр текста — легенда, стихотворение, притча, воспоминание, очерк

- Тема текста — в любом произведении есть своя тема

- Какие использованы приемы построения текста — повторы, противопоставления, усиление, динамичность, созерцание

- Использование изобразительных средств

- Общее впечатление от прочитанного — если вдумчиво читать текст, то определенное впечатление обязательно останется, о нем и следует рассказать в самом конце анализа

Пример

Как делать анализ текста представленного отрывка? Ниже приведен пример:

Следует разобрать его по шагам, чтобы увидеть заложенный смысл.

- Мысль автора — показать и рассказать об участниках охоты, а с другой стороны продемонстрировать величие природы.

- Тип и стиль — это художественное произведение, а точнее повествование с элементами описания.

- Средства связи и художественные средства — союзы (и, но), наречия (долго, крепко, вдали). Основной прием — антитеза, т.е. когда идет противопоставление — глаголы (выскочишь, помчишься и осадишь, замирает), прилагательные (отчаянный, бешенный и мертвый). Также встречаются эпитеты, метафоры, градации.

- Синтаксические особенности — используются простые предложения, которые также входят в состав сложных, распространены определения и обстоятельства.

- Орфографические особенности — безударные гласные в корне (копыта, долина), чередующиеся гласные в корне (замирают, выскочишь).

Лексический анализ текста / Справочник :: Бингоскул

Лексический анализ текста: пример добавить в закладки удалить из закладокСодержание:

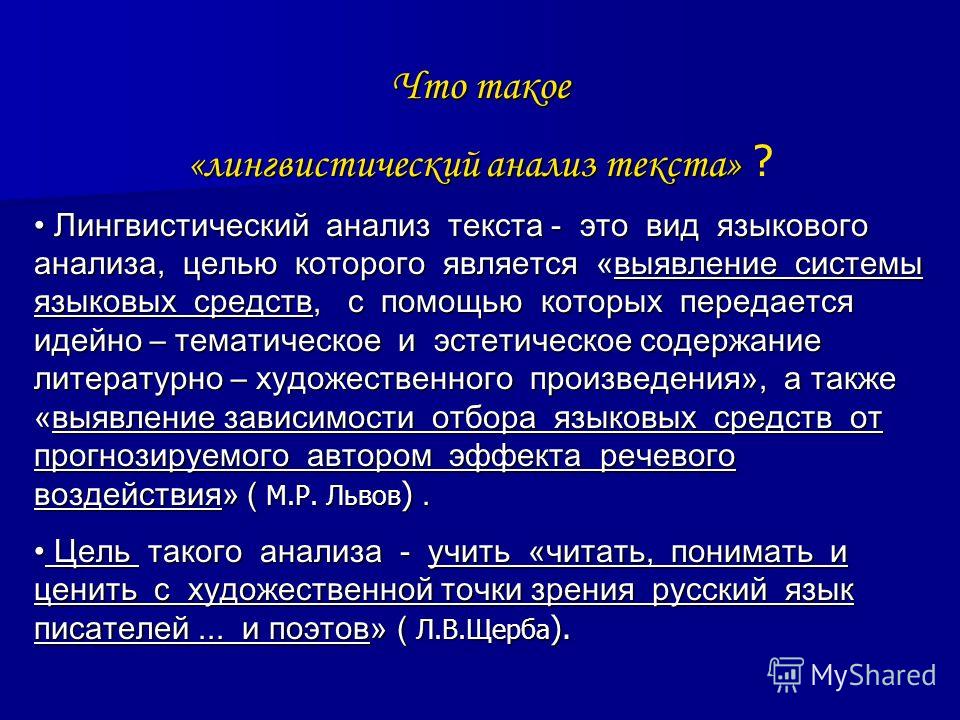

Лексический анализ текста – важная составляющая для развития речи и расширения словарного запаса. Хорошее понимание лексического значения слова, умение определять синонимы, омонимы, антонимы, формирование навыков употребления художественно-выразительных средств для обогащения речи, правильное использование фразеологических оборотов и устойчивых словосочетаний – все эти навыки помогает приобрести детальный разбор текста.

Хорошее понимание лексического значения слова, умение определять синонимы, омонимы, антонимы, формирование навыков употребления художественно-выразительных средств для обогащения речи, правильное использование фразеологических оборотов и устойчивых словосочетаний – все эти навыки помогает приобрести детальный разбор текста.

Как делать лексический анализ текста?

Для выполнения лексического анализа необходимо:

- внимательно прочитать текст;

- определить стиль текста, т.к. каждый из них имеет особенности при анализе лексики;

- выделить слова и выражения, передающие основную тему и идею текста;

- провести исследование отдельных слов и выражений, при необходимости использовать словари.

План лексического анализа текста

1. Определить стиль текста.

Стили:

- художественный;

- публицистический;

- официально-деловой;

- разговорный;

- научный.

2. Определитm тему и основную идею.

3. Выделить ключевые слова.

Ключевые слова – это опорные фрагменты текста, которые передают содержание. Пересказ текста строится именно на ключевых словах и выражениях.

4. Выделить лексически окрашенные слова:

- для художественного текста – метафоры, сравнения, олицетворения, эпитеты, аллегория, гипербола, метонимия и др.;

- для публицистического стиля – общественно-социальная, общественно-политическая лексика;

- для официально-делового стиля – канцеляризмы;

- для разговорного стиля – слова, характерные для непринужденной беседы, бытовых ситуаций, использование уменьшительно-ласкательных слов, междометий;

- для научного стиля – термины, узкоспециальная лексика.

5. Выделить стилистические фигуры. К стилистическим фигурам относятся: инверсия, риторический вопрос, параллелизм, анафора, градация и др.

6. Найти синонимы, антонимы, омонимы, используемые в тексте, объяснить их роль.

7. Обозначить неологизмы, диалектизмы, профессионализмы, фразеологизмы, заимствованные слова. Используя словарь, объяснить их лексическое значение.

Пример лексического анализа текста

Как неожиданно и ярко…

Как неожиданно и ярко,На влажной неба синеве,

душная воздвиглась арка

В своем минутном торжестве!

Один конец в леса вонзила,

Другим за облака вошла –

Она полнеба обхватила

И в высоте изнемогла.

О, в этом радужном виденье

Какая нега для очей!

Оно дано нам на мгновенье,

Лови его – лови скорей!

Смотри – оно уж побледнело,

Ушло, как то уйдет всецело,

Чем ты и дышишь, и живешь.

(Ф.И.Тютчев)

Лирическое произведение написано Ф.И.Тютчевым в 1865 г.

- Стиль текста – художественный.

- Произведение относится к пейзажной лирике, поэт с восхищением описывает красивое природное явление – радугу.

Стихотворение представляет собой философское размышление о том, что все в жизни рано или поздно проходит

- Ключевые слова и выражения, передающие тему и идею текста: «воздушная арка», «в минутном торжестве», «полнеба обхватила», «радужное виденье», «лови мгновенье», «уйдет всецело».

- Художественно-изобразительные средства:

- эпитеты: «влажной синеве», «неожиданно и ярко», «воздушная арка», «минутное тортво», «радужном виденье»;

- метафоры: «воздвиглась арка»; слово «арка» употреблено в переносном значении, основывается на внешнем сходстве с радугой

- олицетворения: «за облака вошла», «полнеба обхватила», «в высоте изнемогла». Эпитеты и метафоры автором используются для передачи эмоционального состояния восторга и восхищения радугой, олицетворения позволяют создать еще более яркий образ.

- Стилистические фигуры:

- инверсия: «воздушная воздвиглась арка»;

- риторический вопрос: «Еще минута, две – и что ж?»;

- повтор: «Лови его – лови скорей!»

- В данном тексте в качестве синонимов используются слова: «вонзила», «вошла».

Лексическое значение слова «вонзить» — воткнуть что-нибудь острое.

Лексическое значение слова «вошла» — попасть внутрь чего-нибудь.

В тексте есть контекстные антонимы: «воздвиглась» (т.е. появилась) – «побледнело» (в значении «исчезло»).

Чтобы создать настроение торжественности и особенности момента поэт использует высокую книжную лексику: «нега», «изнемогла», «очей», «виденье».

Лексические значения:

Нега – состояние полного удовлетворения, спокойствия.

Изнемогла – ослабла, потеряла силу.

Очи – глаза.

Виденье – возникшее в воображении, легкое и чуть уловимое.

Такую же роль выполняет слово «торжество», употребленное в значении «чувство радости и удовлетворения»

Смотри также:

- Лексическое значение слова

- Лексический анализ слова

- Синонимы. Антонимы. Омонимы

- Группы слов по происхождению и употреблению

Поделитесь в социальных сетях:

17 декабря 2020, 12:08

Could not load xLike class!

Анализ текста с помощью Python · vipinajayakumar

Я ненавижу анализировать файлы, но это то, что мне приходилось делать в начале почти каждого проекта. Разбор не простой, и может стать камнем преткновения для новичков. Однако, как только вы освоитесь с разбором файлов, вам больше не придется беспокоиться об этой части проблемы. Вот почему я рекомендую новичкам освоиться с разбором файлов на раннем этапе обучения программированию. Эта статья предназначена для начинающих пользователей Python, которым интересно научиться анализировать текстовые файлы.

Разбор не простой, и может стать камнем преткновения для новичков. Однако, как только вы освоитесь с разбором файлов, вам больше не придется беспокоиться об этой части проблемы. Вот почему я рекомендую новичкам освоиться с разбором файлов на раннем этапе обучения программированию. Эта статья предназначена для начинающих пользователей Python, которым интересно научиться анализировать текстовые файлы.

В этой статье я познакомлю вас со своей системой разбора файлов. Я кратко коснусь парсинга файлов в стандартных форматах, но хочу сосредоточиться на парсинге сложных текстовых файлов. Что я подразумеваю под комплексом? Что ж, к этому мы еще вернемся, юный падаван.

Для справки: набор слайдов, который я использую для презентации по этой теме, доступен здесь. Весь код и образцы текста, которые я использую, доступны в моем репозитории Github здесь.

Сначала разберемся, в чем проблема. Зачем нам вообще нужно разбирать файлы? В воображаемом мире, где все данные существуют в одном и том же формате, можно было бы ожидать, что все программы будут вводить и выводить эти данные. Не было бы необходимости анализировать файлы. Однако мы живем в мире, где существует большое разнообразие форматов данных. Некоторые форматы данных лучше подходят для разных приложений. Можно ожидать, что отдельная программа будет обслуживать только некоторые из этих форматов данных. Итак, неизбежно возникает необходимость конвертировать данные из одного формата в другой для использования разными программами. Иногда данные даже не в стандартном формате, что немного усложняет задачу.

Не было бы необходимости анализировать файлы. Однако мы живем в мире, где существует большое разнообразие форматов данных. Некоторые форматы данных лучше подходят для разных приложений. Можно ожидать, что отдельная программа будет обслуживать только некоторые из этих форматов данных. Итак, неизбежно возникает необходимость конвертировать данные из одного формата в другой для использования разными программами. Иногда данные даже не в стандартном формате, что немного усложняет задачу.

Итак, что такое синтаксический анализ?

- Анализ

- Разобрать (строку или текст) на логические синтаксические компоненты.

Мне не нравится приведенное выше определение из Оксфордского словаря. Итак, вот мое альтернативное определение.

- Анализ

- Преобразование данных определенного формата в более удобный формат.

Имея в виду это определение, мы можем представить, что наш ввод может быть в любом формате. Итак, первый шаг при столкновении с любой проблемой синтаксического анализа — понять формат входных данных. Если повезет, будет документация, описывающая формат данных. Если нет, возможно, вам придется самостоятельно расшифровать формат данных. Это всегда весело.

Если повезет, будет документация, описывающая формат данных. Если нет, возможно, вам придется самостоятельно расшифровать формат данных. Это всегда весело.

Как только вы поймете входные данные, следующим шагом будет определение более удобного формата. Ну, это полностью зависит от того, как вы планируете использовать данные. Если программа, в которую вы хотите передать данные, ожидает формат CSV, то это ваш конечный продукт. Для дальнейшего анализа данных я настоятельно рекомендую считать данные в pandas

Если вы аналитик данных Python, то, скорее всего, вы знакомы с pandas. Это пакет Python, который предоставляет DataFrame и другие функции для невероятно мощного анализа данных с минимальными усилиями. Это абстракция поверх Numpy, которая предоставляет многомерные массивы, подобные Matlab. DataFrame — это двумерный массив, но он может иметь несколько индексов строк и столбцов, которые pandas называет MultiIndex , что по существу позволяет хранить многомерные данные. Операции в стиле SQL или базы данных можно легко выполнять с помощью pandas (сравнение с SQL). Pandas также поставляется с набором инструментов ввода-вывода, который включает функции для работы с CSV, MS Excel, JSON, HDF5 и другими форматами данных.

Операции в стиле SQL или базы данных можно легко выполнять с помощью pandas (сравнение с SQL). Pandas также поставляется с набором инструментов ввода-вывода, который включает функции для работы с CSV, MS Excel, JSON, HDF5 и другими форматами данных.

Хотя мы хотели бы считывать данные в многофункциональную структуру данных, такую как pandas DataFrame , было бы очень неэффективно создавать пустой DataFrame и напрямую записывать в него данные. DataFrame — это сложная структура данных, и запись чего-то в DataFrame поэлементно требует больших вычислительных ресурсов. Гораздо быстрее читать данные в примитивный тип данных, такой как list или dict . Как только список или словарь создан, pandas позволяет нам легко преобразовать его в DataFrame , как вы увидите позже. На изображении ниже показан стандартный процесс разбора любого файла.

Если ваши данные имеют стандартный или достаточно близкий формат, то, вероятно, уже существует пакет, который можно использовать для чтения данных с минимальными усилиями.

Допустим, у нас есть файл CSV, data.txt:

a,b,c 1,2,3 4,5,6 7,8,9

Вы легко справитесь с этим с пандами.

123 | импортировать панд как pd

df = pd.read_csv('data.txt')

df |

а б в 0 1 2 3 1 4 5 6 2 7 8 9

Python невероятен, когда дело доходит до работы со строками. Стоит усвоить все распространенные строковые операции. Мы можем использовать эти методы для извлечения данных из строки, как вы можете видеть в простом примере ниже.

1 2 3 4 5 6 7 8 9101112131415161718192021 | my_string = 'Имена: Ромео, Джульетта'

# разделить строку на ':'

step_0 = my_string.split(':')

# получаем первый фрагмент списка

шаг_1 = шаг_0[1]

# разделить строку на ','

step_2 = step_1.split(',')

# удаляем пробелы в начале и конце каждого элемента списка

step_3 = [name. |

Шаг 0: ['Имена', 'Ромео, Джульетта'] Шаг 1: Ромео, Джульетта Шаг 2: ['Ромео', 'Джульетта'] Шаг 3: ['Ромео', 'Джульетта'] Окончательный результат за один раз: ['Ромео', 'Джульетта']

Как вы видели в предыдущих двух разделах, если проблема синтаксического анализа проста, мы могли бы просто использовать существующий анализатор или некоторые строковые методы. Однако жизнь не всегда так проста. Как нам разобрать сложный текстовый файл?

Шаг 1. Разберитесь с форматом ввода

123 | с файлом open('sample.txt'):

file_contents = файл. |

Образец текста В викторине приняли участие ученики Ривердейл Хай и Хогвартса. Ниже приводится запись их результатов. Школа = Средняя школа Ривердейла Оценка = 1 Номер студента, имя 0, Фиби 1, Рэйчел Номер студента, Балл 0, 3 1, 7 Оценка = 2 Номер студента, имя 0, Анджела 1, Тристан 2, Аврора Номер студента, Балл 0, 6 1, 3 2, 9Школа = Хогвартс Оценка = 1 Номер студента, имя 0, Джинни 1, Луна Номер студента, Балл 0, 8 1, 7 Оценка = 2 Номер студента, имя 0, Гарри 1, Гермиона Номер студента, Балл 0, 5 1, 10 Оценка = 3 Номер студента, имя 0, Фред 1, Джордж Номер студента, Балл 0, 0 1, 0

Довольно сложный входной файл! Фу! Данные, которые он содержит, довольно просты, как вы можете видеть ниже:

Name Score.

Номер учащегося класса школы

Хогвартс 1 0 Джинни 8

1 Луна 7

2 0 Гарри 5

1 Гермиона 10

3 0 Фред 0

1 Джордж 0

Ривердейл Хай 1 0 Фиби 3

1 Рэйчел 7

2 0 Анжела 6

1 Тристан 3

2 Аврора 9 Образец текста похож на CSV, поскольку в нем используются запятые для разделения некоторой информации. В верхней части файла есть заголовок и некоторые метаданные. Есть пять переменных: школа, класс, номер ученика, имя и балл. Ключами являются школа, класс и номер ученика. Имя и Оценка являются полями. Для данной школы, класса, номера учащегося есть имя и оценка. Другими словами, школа, класс и номер учащегося вместе образуют составной ключ.

В верхней части файла есть заголовок и некоторые метаданные. Есть пять переменных: школа, класс, номер ученика, имя и балл. Ключами являются школа, класс и номер ученика. Имя и Оценка являются полями. Для данной школы, класса, номера учащегося есть имя и оценка. Другими словами, школа, класс и номер учащегося вместе образуют составной ключ.

Данные представлены в иерархическом формате. Сначала объявляется школа, затем класс. Затем следуют две таблицы, содержащие имя и балл для каждого номера учащегося. Затем увеличивается оценка. Далее следует еще один набор таблиц. Затем картина повторяется для другой школы. Обратите внимание, что количество учащихся в классе или количество классов в школе не являются постоянными, что немного усложняет файл. Это всего лишь небольшой набор данных. Вы можете легко представить, что это массивный файл с множеством школ, классов и учеников.

Само собой разумеется, что формат данных исключительно плохой. Я сделал это намеренно. Если вы понимаете, как с этим обращаться, вам будет намного проще освоить более простые форматы. Нередко встречаются такие файлы, если приходится иметь дело с большим количеством устаревших систем. В прошлом, когда эти системы разрабатывались, возможно, не требовалось, чтобы вывод данных был машиночитаемым. Однако в настоящее время все должно быть машиночитаемым!

Нередко встречаются такие файлы, если приходится иметь дело с большим количеством устаревших систем. В прошлом, когда эти системы разрабатывались, возможно, не требовалось, чтобы вывод данных был машиночитаемым. Однако в настоящее время все должно быть машиночитаемым!

Шаг 2: Импортируйте необходимые пакеты

Нам понадобится модуль регулярных выражений и пакет pandas. Итак, давайте продолжим и импортируем их.

12 | импорт повторно import pandas as pd |

Шаг 3: определение регулярных выражений

На последнем шаге мы импортировали re, модуль регулярных выражений. Что это такое?

Ранее мы видели, как использовать строковые методы для извлечения данных из текста. Однако при синтаксическом анализе сложных файлов мы можем столкнуться с большим количеством зачистки, разделения, нарезки и многого другого, и код может выглядеть довольно нечитаемым. Вот тут-то и появляются регулярные выражения. По сути, это крошечный язык, встроенный в Python, который позволяет вам сказать, какой строковый шаблон вы ищете. Кстати, это не уникально для Python (дом на дереве).

Вот тут-то и появляются регулярные выражения. По сути, это крошечный язык, встроенный в Python, который позволяет вам сказать, какой строковый шаблон вы ищете. Кстати, это не уникально для Python (дом на дереве).

Вам не нужно становиться мастером регулярных выражений. Однако некоторые базовые знания о регулярных выражениях могут оказаться очень полезными в вашей карьере программиста. В этой статье я научу вас только самым основам, но я призываю вас продолжить изучение. Я также рекомендую regexper для визуализации регулярных выражений. regex101 — еще один отличный ресурс для тестирования вашего регулярного выражения.

Нам понадобятся три регулярных выражения. Первый, как показано ниже, поможет нам идентифицировать школу. Его регулярное выражение равно Школа = (.*)\n . Что означают символы?

-

.: Любой символ -

*: 0 или более предыдущего выражения -

(.*): Помещение части регулярного выражения в круглые скобки позволяет сгруппировать эту часть выражения. Итак, в данном случае сгруппированная часть — это название школы.

Итак, в данном случае сгруппированная часть — это название школы. -

\n: Символ новой строки в конце строки

Затем нам нужно регулярное выражение для оценки. Его регулярное выражение равно Оценка = (\d+)\n . Это очень похоже на предыдущее выражение. Новые символы:

-

\d: сокращение от [0-9] . -

+: 1 или более предыдущих выражений

Наконец, нам нужно регулярное выражение, чтобы определить, является ли таблица, которая следует за выражением в текстовом файле, таблицей имен или рейтингов. Его регулярное выражение: (Name|Score) . Новый символ:

-

|: Логическое или утверждение, поэтому в данном случае это означает «Имя» или «Оценка».

Нам также необходимо понять несколько функций регулярных выражений:

-

re.compile(pattern): скомпилировать шаблон регулярного выражения вRegexObject.

RegexObject имеет следующие методы:

-

match(string): если начало строки совпадает с регулярным выражением, вернуть соответствующий экземплярMatchObject. В противном случае вернутьНет. -

search(string): Просканировать строку в поисках места, где это регулярное выражение произвело совпадение, и вернуть соответствующий экземплярMatchObject. ВозвращаетNone, если совпадений нет.

MatchObject всегда имеет логическое значение True . Таким образом, мы можем просто использовать оператор if для выявления положительных совпадений. Он имеет следующий метод:

-

group(): Возвращает одну или несколько подгрупп совпадения. На группы можно ссылаться по их индексу.group(0)возвращает полное совпадение.group(1)возвращает первую подгруппу в скобках и так далее. Используемые нами регулярные выражения имеют только одну группу. Легкий! Однако что, если групп было несколько? Было бы трудно запомнить, к какому номеру принадлежит группа. Специальное расширение Python позволяет нам называть группы и ссылаться на них по имени. Мы можем указать имя внутри группы в скобках

Используемые нами регулярные выражения имеют только одну группу. Легкий! Однако что, если групп было несколько? Было бы трудно запомнить, к какому номеру принадлежит группа. Специальное расширение Python позволяет нам называть группы и ссылаться на них по имени. Мы можем указать имя внутри группы в скобках (...)вот так:(?P<имя>...).

Сначала определим все регулярные выражения. Обязательно используйте необработанные строки для регулярного выражения, т. е. используйте индекс r перед каждым шаблоном.

1234567 | # настроить регулярные выражения

# используйте https://regexper.com, чтобы визуализировать их, если это необходимо

rx_dict = {

'школа': re.compile(r'School = (?P |

Шаг 4: Напишите синтаксический анализатор строк

Затем мы можем определить функцию, которая проверяет соответствие регулярным выражениям.

1 2 3 4 5 6 7 8 910111213 | по определению _parse_line (строка):

"""

Выполните поиск регулярных выражений по всем определенным регулярным выражениям и

вернуть ключ и результат сопоставления первого совпадающего регулярного выражения

"""

для ключа, rx в rx_dict.items():

совпадение = rx.search(строка)

если совпадают:

ключ возврата, совпадение

# если совпадений нет

возврат Нет, Нет |

Шаг 5: Напишите синтаксический анализатор файлов

Наконец, для основного события у нас есть функция синтаксического анализа файлов. Он довольно большой, но комментарии в коде должны помочь вам понять логику.

1 2 3 4 5 6 7 8 910111213141516171819202122232425262728293031323334353637383940414243444546474849505152535455565758 59606162636465 | def parse_file (путь к файлу):

"""

Разобрать текст по указанному пути к файлу

Параметры

----------

путь к файлу: ул

Путь к файлу для file_object для анализа

Возвращает

-------

данные: pd. |

Шаг 6: Проверка синтаксического анализатора

Мы можем использовать наш синтаксический анализатор для нашего образца текста следующим образом:

1234 | , если __name__ == '__main__':

путь к файлу = 'sample.txt'

данные = разбор (путь к файлу)

печать(данные) |

Имя Оценка

Номер учащегося класса школы

Хогвартс 1 0 Джинни 8

1 Луна 7

2 0 Гарри 5

1 Гермиона 10

3 0 Фред 0

1 Джордж 0

Ривердейл Хай 1 0 Фиби 3

1 Рэйчел 7

2 0 Анжела 6

1 Тристан 3

2 Аврора 9 Это все хорошо, и вы можете увидеть, сравнив ввод и вывод на глаз, что парсер работает правильно. Однако лучше всего всегда писать юнит-тесты, чтобы убедиться, что ваш код делает то, для чего вы его планировали. Всякий раз, когда вы пишете синтаксический анализатор, убедитесь, что он хорошо протестирован. У меня возникли проблемы с моими коллегами из-за использования парсеров без тестирования. Эй! Также стоит отметить, что это не обязательно должен быть последний шаг. Действительно, многие программисты проповедуют разработку через тестирование. Я не включил сюда набор тестов, так как хотел, чтобы это руководство было кратким.

Всякий раз, когда вы пишете синтаксический анализатор, убедитесь, что он хорошо протестирован. У меня возникли проблемы с моими коллегами из-за использования парсеров без тестирования. Эй! Также стоит отметить, что это не обязательно должен быть последний шаг. Действительно, многие программисты проповедуют разработку через тестирование. Я не включил сюда набор тестов, так как хотел, чтобы это руководство было кратким.

Я разбирал текстовые файлы в течение года и со временем усовершенствовал свой метод. Тем не менее, я провел дополнительное исследование, чтобы выяснить, есть ли лучшее решение. Действительно, я должен поблагодарить различных членов сообщества, которые посоветовали мне оптимизировать мой код. Сообщество также предложило несколько различных способов разбора текстового файла. Некоторые из них были умными и захватывающими. Мой личный фаворит был этот. Я представил свой пример проблемы и решения на следующих форумах:

- Сообщение Reddit

- Пост переполнения стека

- Сообщение о проверке кода

Если ваша проблема еще более сложна и регулярные выражения не решают ее, то следующим шагом будет рассмотрение разбора библиотек. Вот несколько мест, с которых можно начать:

Вот несколько мест, с которых можно начать:

- Анализ ужасных вещей с помощью Python: Лекция Эрика Роуза о PyCon, в которой рассматриваются плюсы и минусы различных библиотек синтаксического анализа.

- Синтаксический анализ в Python: инструменты и библиотеки: Инструменты и библиотеки, позволяющие создавать парсеры, когда регулярных выражений недостаточно.

Теперь, когда вы понимаете, насколько сложным и утомительным может быть анализ текстовых файлов, если вы когда-нибудь окажетесь в привилегированном положении при выборе формата файла, выбирайте его с осторожностью. Вот лучшие практики Стэнфорда для форматов файлов.

Я бы солгал, если бы сказал, что был в восторге от моего метода синтаксического анализа, но я не знаю другого способа быстрого анализа текстового файла, который так же удобен для новичков, как тот, что я представил выше. Если вы знаете лучшее решение, я весь внимание! Надеюсь, я дал вам хорошую отправную точку для разбора файла в Python! Я провел пару месяцев, пробуя множество разных методов и написав какой-то безумно нечитаемый код, прежде чем наконец понял это, и теперь я не думаю дважды о разборе файла. Итак, я надеюсь, что смог сэкономить вам немного времени. Получайте удовольствие от разбора текста с помощью Python!

Итак, я надеюсь, что смог сэкономить вам немного времени. Получайте удовольствие от разбора текста с помощью Python!

Написание синтаксического анализатора. Часть I. Начало работы | by Supun Setunga

9 мин чтения·

30 августа 2020 г.В этой статье обсуждается простой подход к реализации анализатора рукописного ввода с нуля и некоторые основные принципы, связанные с ним. Это больше фокусируется на объяснении практических аспектов реализации, а не на формальных определениях синтаксических анализаторов.

Синтаксический анализатор — это самое первое, что приходит нам на ум, когда мы говорим о разработке-компиляторе/конструкции-компилятора. Правильно, синтаксический анализатор играет ключевую роль в архитектуре компилятора, а также может рассматриваться как точка входа в компилятор. Прежде чем мы углубимся в детали того, как написать синтаксический анализатор, давайте посмотрим, что на самом деле означает синтаксический анализ.

Что такое синтаксический анализ

Синтаксический анализ по существу означает преобразование исходного кода в древовидное представление объекта, которое называется «деревом синтаксического анализа» (также иногда называемым «синтаксическим деревом»). Часто абстрактное синтаксическое дерево (AST) путают с деревом разбора/синтаксиса. Дерево синтаксического анализа — это конкретное представление исходного кода. Он сохраняет всю информацию об исходном коде, включая тривиальную информацию, такую как разделители, пробелы, комментарии и т. д. Принимая во внимание, что AST является абстрактным представлением исходного кода и может не содержать часть информации, которая есть в исходном коде. .

Часто абстрактное синтаксическое дерево (AST) путают с деревом разбора/синтаксиса. Дерево синтаксического анализа — это конкретное представление исходного кода. Он сохраняет всю информацию об исходном коде, включая тривиальную информацию, такую как разделители, пробелы, комментарии и т. д. Принимая во внимание, что AST является абстрактным представлением исходного кода и может не содержать часть информации, которая есть в исходном коде. .

В дереве синтаксического анализа каждый элемент называется «узлом». Листовые узлы или конечные узлы рассматриваются как узлы особого типа, которые называются «токенами». Нетерминальные узлы обычно называют просто «узел».

Зачем рукописный парсер?

Если вы осмотритесь, то увидите, что существует довольно много доступных генераторов синтаксических анализаторов, таких как ANTLR, Bison, Yacc и т. д. С помощью этих генераторов синтаксических анализаторов мы можем просто определить грамматику и автоматически сгенерировать синтаксический анализатор в соответствии с этой грамматикой. . Это звучит довольно просто! Если да, то зачем писать парсер с нуля?

. Это звучит довольно просто! Если да, то зачем писать парсер с нуля?

Распространенная ошибка при построении компилятора — думать, что нам нужно написать синтаксический анализатор с нуля, или думать, что нам не нужен собственный синтаксический анализатор. Что ж, звучит противоречиво! Загвоздка в том, что оба подхода имеют свои плюсы и минусы. Поэтому важно знать, когда писать парсер вручную или использовать генератор парсеров:

Сгенерированный парсер:

- Простота реализации — Определите грамматику в нужном формате и сгенерируйте парсер. например: Для ANTLR все, что нам нужно, это определить грамматику в

.g4 Формат. Затем сгенерировать синтаксический анализатор так же просто, как запустить одну команду. - Простота обслуживания — все, что вам нужно сделать, это обновить правило грамматики и заново сгенерировать синтаксический анализатор.

- Может быть компактного размера.

- Однако у него нет преимуществ рукописного парсера (см.

ниже).

ниже).

Написанный от руки синтаксический анализатор:

- Написание синтаксического анализатора вручную — задача средней сложности. Сложность может увеличиться, если языковая грамматика сложна. Однако он имеет следующие преимущества.

- Могут быть улучшенные и содержательные сообщения об ошибках. Автоматически сгенерированные парсеры могут иногда приводить к совершенно бесполезным ошибкам.

- Может поддерживать отказоустойчивый синтаксический анализ. Другими словами, он может создать правильное дерево синтаксического анализа даже при синтаксической ошибке. Это также означает, что рукописный синтаксический анализатор может обнаруживать и обрабатывать несколько синтаксических ошибок одновременно. В сгенерированных синтаксических анализаторах это может быть достигнуто в определенной степени с помощью обширных настроек, но может быть не в состоянии полностью поддерживать отказоустойчивый синтаксический анализ.

- Может поддерживать добавочный синтаксический анализ — анализировать только часть кода при обновлении исходного кода.

- Обычно лучше с точки зрения производительности.

- Простота настройки. Вы владеете кодом и имеете полный контроль над ним — например: в ANTLR4, если вы хотите настроить логику синтаксического анализа, вам придется либо расширить и немного взломать сгенерированный синтаксический анализатор, либо написать некоторую пользовательскую логику в сам файл грамматики на другом языке. Иногда это может быть запутанно, а уровень настройки, который можно сделать, очень ограничен.

- Может легко обрабатывать контекстно-зависимые грамматики. Не все языки на 100% контекстно-свободны. Могут быть ситуации, когда вы хотите токенизировать входные данные или построить дерево синтаксического анализа по-разному в зависимости от контекста. Это очень сложная или почти невыполнимая задача, когда речь идет о сгенерированных парсерах.

Итак, в общем, если вы хотите получить высокооптимизированный синтаксический анализатор производственного уровня, который является отказоустойчивым, и если у вас достаточно времени, то рукописный синтаксический анализатор — это то, что вам нужно. С другой стороны, вам нужен достаточно приличный синтаксический анализатор за очень короткое время, а производительность или отказоустойчивость не являются одним из ваших требований, сгенерированный синтаксический анализатор справится с задачей.

С другой стороны, вам нужен достаточно приличный синтаксический анализатор за очень короткое время, а производительность или отказоустойчивость не являются одним из ваших требований, сгенерированный синтаксический анализатор справится с задачей.

Независимо от того, следует ли реализовать рукописный синтаксический анализатор или использовать сгенерированный синтаксический анализатор, всегда будет необходима одна вещь: четко определенная грамматика (формальная грамматика) для языка, который мы собираемся реализовать. Грамматика определяет лексическую и синтаксическую структуру программы на этом языке. Очень популярным и простым форматом для определения контекстно-свободной грамматики является форма Бэкуса-Наура (BNF) или один из ее вариантов, например расширенная форма Бэкуса-Наура (EBNF).

Несмотря на то, что синтаксический анализатор часто называют отдельным компонентом в архитектуре компилятора, он состоит из нескольких компонентов, включая, помимо прочего, лексер, синтаксический анализатор и несколько других абстракций, таких как устройство(а) чтения ввода/символов и обработчик ошибок. На приведенной ниже диаграмме показаны компоненты и то, как они связаны друг с другом в нашей реализации парсера.

На приведенной ниже диаграмме показаны компоненты и то, как они связаны друг с другом в нашей реализации парсера.

Считыватель символов / Считыватель ввода

Считыватель символов, также называемый устройством чтения ввода, считывает исходный код и предоставляет символы/кодовые точки лексеру по запросу. Исходным кодом может быть что угодно: файл, входной поток или даже строка.

Также возможно встроить возможности чтения ввода в сам лексер. Однако преимущество абстрагирования считывателя от лексера состоит в том, что, в зависимости от входных данных, мы можем подключать разные считыватели к одному и тому же лексеру. И лексеру не нужно беспокоиться об обработке различных типов входных данных.

Считыватель ввода состоит из трех наборов важных методов:

- peek()/peek(k) — Получить следующий символ /следующий k-й символ из ввода. Это используется для просмотра символов без их использования/удаления из входного потока. Вызов метода

peek()более одного раза вернет один и тот же символ.

- потреблять()/consume(k) — Получить следующий символ /следующий k-й токен из ввода и удалить его из ввода. Это означает, что вызов

метод Consumer()несколько раз будет возвращать новый символ при каждом вызове. Иногда этот методserve()также называютread()илиnext(). - isEOF() — Проверяет, достиг ли читатель конца ввода.

Лексер

Лексер считывает символы из устройства ввода/считывания символов и создает токены. Другими словами, он преобразует поток символов в поток маркеров. Поэтому его иногда также называют токенизатором. Эти токены создаются в соответствии с определенной грамматикой. Обычно реализация лексера несколько сложнее, чем у считывателя символов, но гораздо проще, чем у синтаксического анализатора.

Важным аспектом лексера является обработка пробелов и комментариев. В большинстве языков языковая семантика не зависит от пробелов. Пробелы требуются только для обозначения конца токена и, следовательно, также называются «пустяками» или «мелоциями», поскольку они не имеют большого значения для AST. Однако это не относится ко всем языкам, потому что в некоторых языках, таких как python, пробелы могут иметь семантическое значение. Разные лексеры по-разному обрабатывают эти пробелы и комментарии:

Пробелы требуются только для обозначения конца токена и, следовательно, также называются «пустяками» или «мелоциями», поскольку они не имеют большого значения для AST. Однако это не относится ко всем языкам, потому что в некоторых языках, таких как python, пробелы могут иметь семантическое значение. Разные лексеры по-разному обрабатывают эти пробелы и комментарии:

- Отбросить их в лексере — Недостаток этого подхода в том, что он не сможет воспроизвести исходный код из дерева синтаксиса/анализа. Это может стать проблемой, если вы планируете использовать дерево синтаксического анализа для таких целей, как форматирование кода и т. д.

- Выдавать пробелы как отдельные токены, но в поток/канал, отличный от обычного токена. Это хороший подход для языков, в которых пробелы имеют семантическое значение.

- Сохраните их в дереве синтаксического анализа, присоединив их к ближайшему токену. В нашей реализации мы будем использовать этот подход.

Как и считыватель символов, lexer состоит из двух методов:

- peek()/peek(k) — Получить следующий токен /следующий k-й токен.

Это используется для просмотра токенов без их использования/удаления из входного потока. Вызов метода

Это используется для просмотра токенов без их использования/удаления из входного потока. Вызов метода peek()более одного раза вернет один и тот же токен. - потреблять()/consume(k) — Получить следующий токен/следующий k-й токен и удалить его из потока токенов. Это означает, что по телефону

Потребление ()несколько раз будет возвращать новый токен при каждом вызове. Иногда этот методserve()также называютread()илиnext().

Как только лексер достигает конца ввода от устройства чтения символов, он выдает специальный токен, называемый «EOFToken» (маркер конца файла). Синтаксический анализатор использует этот EOFToken для завершения синтаксического анализа.

Анализатор

Анализатор отвечает за чтение токенов из лексера и создание дерева разбора. Он получает следующий токен от лексера, анализирует его и сравнивает с определенной грамматикой. Затем решает, какое из грамматических правил следует учитывать, и продолжает разбор в соответствии с грамматикой. Однако это не всегда очень просто, так как иногда невозможно определить, какой путь выбрать, только взглянув на следующий токен. Таким образом, синтаксическому анализатору, возможно, придется проверить несколько токенов в будущем, чтобы решить, какой путь или правило грамматики следует учитывать. Об этом мы подробно поговорим в следующей статье. Однако из-за такой сложности парсер также является наиболее сложным компонентом для реализации в архитектуре парсера.

Однако это не всегда очень просто, так как иногда невозможно определить, какой путь выбрать, только взглянув на следующий токен. Таким образом, синтаксическому анализатору, возможно, придется проверить несколько токенов в будущем, чтобы решить, какой путь или правило грамматики следует учитывать. Об этом мы подробно поговорим в следующей статье. Однако из-за такой сложности парсер также является наиболее сложным компонентом для реализации в архитектуре парсера.

Как правило, синтаксическому анализатору требуется только один метод — метод parse() , который выполняет весь синтаксический анализ и возвращает дерево синтаксического анализатора.

Учитывая тот факт, что наша цель состоит в том, чтобы реализовать синтаксический анализатор, который одновременно является устойчивым и выдает правильные сообщения об ошибках, очень важным аспектом синтаксического анализатора является правильная обработка синтаксических ошибок. Синтаксическая ошибка — это случай, когда во время синтаксического анализа достигается неожиданный токен или, другими словами, следующий токен не соответствует определенной грамматике. В таких случаях синтаксический анализатор запрашивает «обработчик ошибок» (см. следующий раздел) исправить эту синтаксическую ошибку, и как только обработчик ошибок восстанавливается, синтаксический анализатор продолжает анализировать остальную часть ввода.

В таких случаях синтаксический анализатор запрашивает «обработчик ошибок» (см. следующий раздел) исправить эту синтаксическую ошибку, и как только обработчик ошибок восстанавливается, синтаксический анализатор продолжает анализировать остальную часть ввода.

Обработчик ошибок

Как обсуждалось в предыдущем разделе, целью обработчика ошибок является восстановление после синтаксической ошибки. Он играет ключевую роль в современном отказоустойчивом синтаксическом анализаторе, особенно для создания корректного дерева синтаксического анализа даже с синтаксическими ошибками и выдачи правильных и содержательных сообщений об ошибках.

Возможности обработки ошибок также могут быть встроены в сам синтаксический анализатор. Преимущество этого заключается в том, что, поскольку ошибки будут обрабатываться тут же в синтаксическом анализаторе, в момент восстановления доступно много контекстной информации. Однако недостатков у встраивания возможностей восстановления в сам парсер больше, чем достоинств:

- Попытка восстановить каждое место приведет к большому количеству повторяющихся задач и повторяющихся кодов.

strip() для имени в step_2]

# делаем все вышеперечисленные операции за один раз

one_go = [name.strip() для имени в my_string.split(':')[1].split(',')]

для idx, элемент в перечислении ([шаг_0, шаг_1, шаг_2, шаг_3]):

print("Шаг {}: {}".format(idx, элемент))

print("Окончательный результат за один раз: {}".format(one_go))

strip() для имени в step_2]

# делаем все вышеперечисленные операции за один раз

one_go = [name.strip() для имени в my_string.split(':')[1].split(',')]

для idx, элемент в перечислении ([шаг_0, шаг_1, шаг_2, шаг_3]):

print("Шаг {}: {}".format(idx, элемент))

print("Окончательный результат за один раз: {}".format(one_go))  чтение()

print(file_contents)

чтение()

print(file_contents)  Итак, в данном случае сгруппированная часть — это название школы.

Итак, в данном случае сгруппированная часть — это название школы.

Используемые нами регулярные выражения имеют только одну группу. Легкий! Однако что, если групп было несколько? Было бы трудно запомнить, к какому номеру принадлежит группа. Специальное расширение Python позволяет нам называть группы и ссылаться на них по имени. Мы можем указать имя внутри группы в скобках

Используемые нами регулярные выражения имеют только одну группу. Легкий! Однако что, если групп было несколько? Было бы трудно запомнить, к какому номеру принадлежит группа. Специальное расширение Python позволяет нам называть группы и ссылаться на них по имени. Мы можем указать имя внутри группы в скобках  DataFrame

Проанализированные данные

"""

data = [] # создаем пустой список для сбора данных

# открываем файл и читаем его построчно

с открытым (путь к файлу, 'r') как файл_объект:

строка = файл_объект.readline()

пока строка:

# в каждой строке проверяем совпадение с регулярным выражением

ключ, совпадение = _parse_line (строка)

# извлечь название школы

если ключ == 'школа':

школа = match.group('школа')

# степень извлечения

если ключ == 'оценка':

оценка = match.group('оценка')

класс = инт (класс)

# идентифицируем заголовок таблицы

если ключ == 'name_score':

# извлечь тип таблицы, т. е. имя или счет

value_type = match.group('name_score')

строка = файл_объект.readline()

# читать каждую строку таблицы до пустой строки

в то время как line.

DataFrame

Проанализированные данные

"""

data = [] # создаем пустой список для сбора данных

# открываем файл и читаем его построчно

с открытым (путь к файлу, 'r') как файл_объект:

строка = файл_объект.readline()

пока строка:

# в каждой строке проверяем совпадение с регулярным выражением

ключ, совпадение = _parse_line (строка)

# извлечь название школы

если ключ == 'школа':

школа = match.group('школа')

# степень извлечения

если ключ == 'оценка':

оценка = match.group('оценка')

класс = инт (класс)

# идентифицируем заголовок таблицы

если ключ == 'name_score':

# извлечь тип таблицы, т. е. имя или счет

value_type = match.group('name_score')

строка = файл_объект.readline()

# читать каждую строку таблицы до пустой строки

в то время как line. strip():

# извлечь число и значение

число, значение = line.strip().split(',')

значение = значение.strip()

# создать словарь, содержащий эту строку данных

строка = {

«Школа»: школа,

«Оценка»: оценка,

«Номер студента»: номер,

тип_значения: значение

}

# добавляем словарь в список данных

data.append(строка)

строка = файл_объект.readline()

строка = файл_объект.readline()

# создать pandas DataFrame из списка диктов

данные = pd.DataFrame(данные)

# установить номер школы, класса и ученика в качестве индекса

data.set_index(['Школа', 'Оценка', 'Номер ученика'], inplace=True)

# объединить df, чтобы удалить nans

данные = данные.группа(уровень=данные.индекс.имена).первый()

# обновить Score с float до integer

data = data.

strip():

# извлечь число и значение

число, значение = line.strip().split(',')

значение = значение.strip()

# создать словарь, содержащий эту строку данных

строка = {

«Школа»: школа,

«Оценка»: оценка,

«Номер студента»: номер,

тип_значения: значение

}

# добавляем словарь в список данных

data.append(строка)

строка = файл_объект.readline()

строка = файл_объект.readline()

# создать pandas DataFrame из списка диктов

данные = pd.DataFrame(данные)

# установить номер школы, класса и ученика в качестве индекса

data.set_index(['Школа', 'Оценка', 'Номер ученика'], inplace=True)

# объединить df, чтобы удалить nans

данные = данные.группа(уровень=данные.индекс.имена).первый()

# обновить Score с float до integer

data = data. apply(pd.to_numeric, errors='игнорировать')

вернуть данные

apply(pd.to_numeric, errors='игнорировать')

вернуть данные  ниже).

ниже).

Это используется для просмотра токенов без их использования/удаления из входного потока. Вызов метода

Это используется для просмотра токенов без их использования/удаления из входного потока. Вызов метода